La historia de la informática es una narrativa rica y compleja que ha transformado radicalmente nuestra sociedad. Desde los primeros dispositivos de cálculo hasta las computadoras cuánticas y la inteligencia artificial, la informática ha evolucionado de manera impresionante. Este artículo recorrerá los hitos más importantes en la historia de la informática, las generaciones de computadoras y las innovaciones más recientes en el campo. A lo largo de este recorrido, destacaremos las contribuciones significativas y los avances tecnológicos que han moldeado el mundo en que vivimos hoy.

Los primeros dispositivos de cálculo

La historia de la informática se remonta a los primeros dispositivos de cálculo, que fueron esenciales para las primeras civilizaciones en la resolución de problemas aritméticos. Uno de los primeros inventos fue el ábaco, utilizado por civilizaciones antiguas como los babilonios y los chinos para realizar operaciones matemáticas básicas. El ábaco permitió realizar cálculos de manera rápida y eficiente, y su diseño básico ha perdurado a lo largo de los siglos.

Otro avance significativo en la historia de los dispositivos de cálculo fue la máquina de Anticitera, un antiguo dispositivo griego utilizado para predecir posiciones astronómicas y eclipses. Descubierta en un naufragio cerca de la isla de Anticitera, esta compleja máquina mecánica data del siglo I a.C. y es considerada uno de los primeros ejemplos de un mecanismo de engranajes diferenciales.

En el siglo XVII, el matemático y filósofo francés Blaise Pascal inventó la Pascalina, una calculadora mecánica que podía realizar sumas y restas. La Pascalina utilizaba una serie de ruedas dentadas y engranajes para realizar cálculos de manera automática, lo que representó un avance significativo en la automatización de procesos matemáticos. Poco después, el matemático alemán Gottfried Wilhelm Leibniz desarrolló la rueda de Leibniz, capaz de realizar multiplicaciones y divisiones. Estas primeras máquinas de cálculo sentaron las bases para el desarrollo de dispositivos más avanzados en los siglos posteriores.

La revolución industrial y las máquinas analíticas

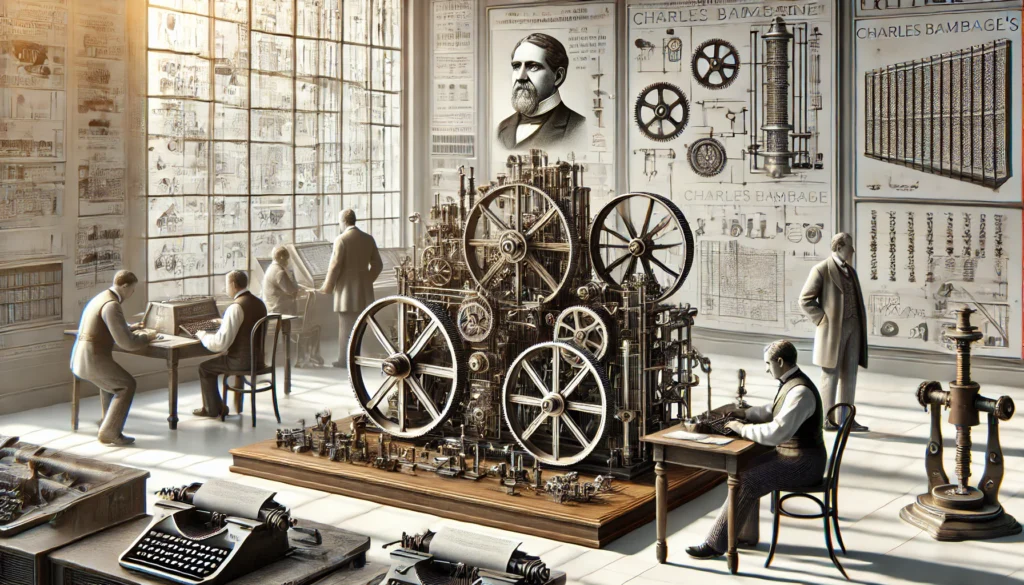

Durante la Revolución Industrial, la necesidad de realizar cálculos complejos impulsó el desarrollo de máquinas analíticas. Charles Babbage, conocido como el “padre de la computación”, diseñó en 1837 la Máquina Analítica, una computadora mecánica programable. La Máquina Analítica de Babbage estaba destinada a ser una máquina de propósito general capaz de realizar cualquier cálculo matemático mediante la utilización de tarjetas perforadas para la entrada de datos y la programación. Aunque nunca fue construida en su tiempo, el diseño de Babbage sentó las bases para las futuras computadoras.

Ada Lovelace, una matemática británica, trabajó con Babbage y es considerada la primera programadora de computadoras. Lovelace escribió el primer algoritmo destinado a ser procesado por una máquina, reconociendo el potencial de las computadoras para realizar tareas más allá de los cálculos matemáticos. Su visión y comprensión de la Máquina Analítica fueron revolucionarias, y sus contribuciones han sido fundamentales para el desarrollo de la programación informática.

En paralelo a los trabajos de Babbage y Lovelace, otros inventores y científicos también estaban desarrollando sus propios dispositivos de cálculo. Por ejemplo, el francés Joseph-Marie Jacquard inventó el telar de Jacquard, que utilizaba tarjetas perforadas para controlar el patrón tejido por el telar. Esta innovación fue crucial para el desarrollo de la programación y la automatización en la informática.

La era de las computadoras electromecánicas y electrónicas

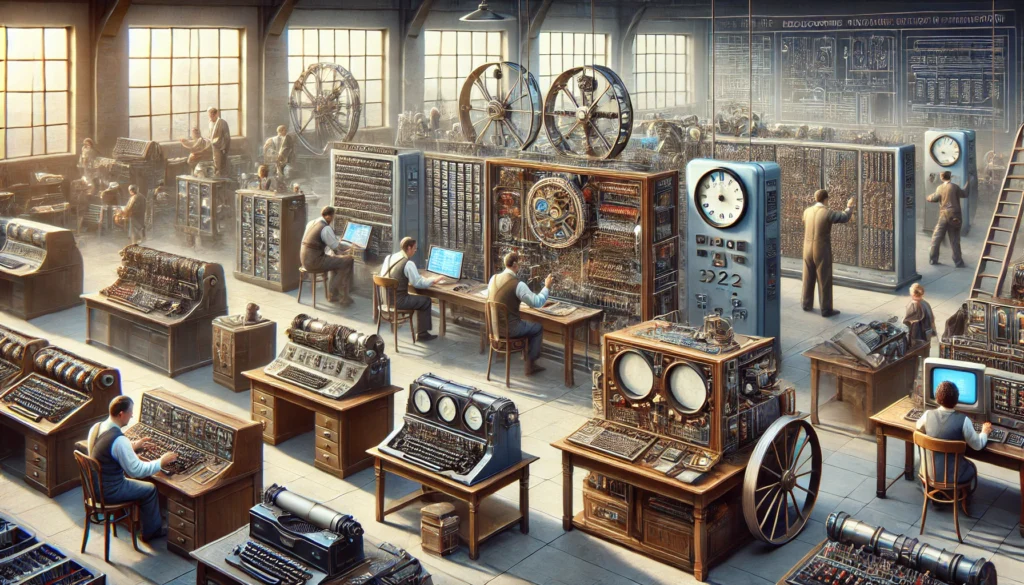

A principios del siglo XX, se desarrollaron las computadoras electromecánicas y electrónicas. En 1936, Alan Turing, un matemático británico, propuso la máquina de Turing, un modelo teórico de una computadora universal. Este concepto fue fundamental para el desarrollo de la informática teórica y la comprensión de los límites y capacidades de las máquinas de computación. La máquina de Turing proporcionó una base conceptual para la construcción de computadoras y el desarrollo de algoritmos.

Durante la Segunda Guerra Mundial, se crearon las primeras computadoras electrónicas para descifrar códigos y realizar cálculos balísticos. La Colossus, desarrollada por los británicos, fue una de las primeras computadoras electrónicas y se utilizó para descifrar los mensajes encriptados de los alemanes. La ENIAC, desarrollada por los estadounidenses, fue completada en 1945 y era capaz de realizar 5,000 sumas por segundo. La ENIAC fue utilizada para cálculos balísticos y otros fines militares, y marcó un hito importante en la historia de la computación.

En paralelo a estos desarrollos, el matemático estadounidense John von Neumann propuso la arquitectura de von Neumann, que se convirtió en el modelo de referencia para las computadoras modernas. Esta arquitectura se basa en la idea de que la memoria de una computadora puede almacenar tanto datos como instrucciones, lo que permite la programación y la ejecución de programas de manera eficiente.

Las generaciones de computadoras

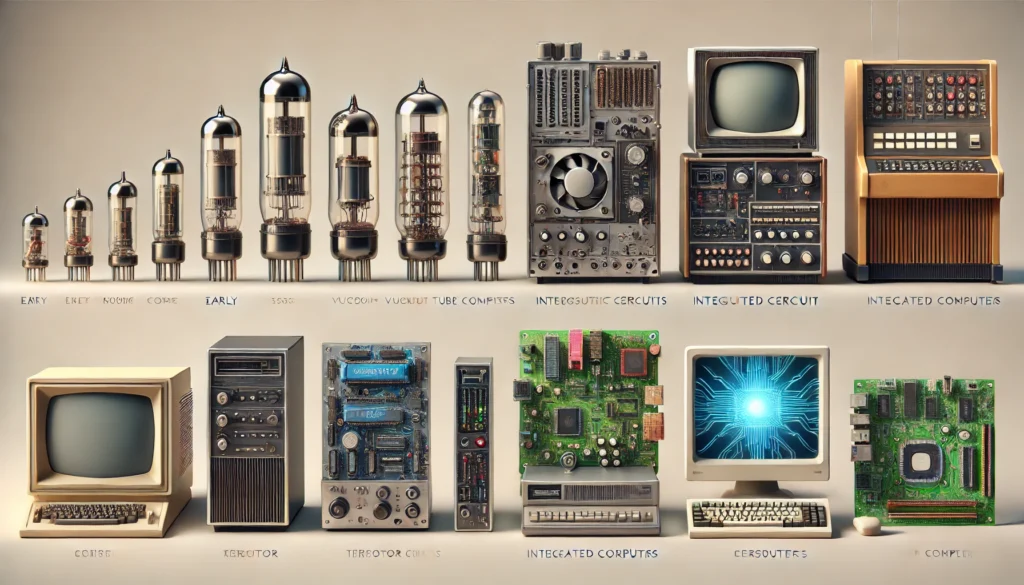

La historia de las computadoras se divide en varias generaciones, cada una marcada por avances tecnológicos significativos.

Primera generación (1940-1956): Las primeras computadoras utilizaban tubos de vacío para procesar información. Eran enormes, costosas y consumían mucha energía. La UNIVAC I, desarrollada en 1951, fue la primera computadora comercial de esta generación y se utilizó para el procesamiento de datos en el censo de los Estados Unidos. Aunque estas máquinas eran primitivas en comparación con las computadoras modernas, representaron un avance significativo en la automatización de procesos y el manejo de grandes cantidades de datos.

Segunda generación (1956-1963): Las computadoras de esta generación utilizaban transistores en lugar de tubos de vacío, lo que las hacía más pequeñas, rápidas y eficientes. Los transistores permitieron la miniaturización de los componentes y la reducción del consumo de energía. El IBM 1401 es un ejemplo representativo de esta generación y se utilizó ampliamente en empresas para la gestión de datos y la contabilidad.

Tercera generación (1964-1971): El desarrollo de circuitos integrados permitió la creación de computadoras aún más pequeñas y poderosas. Los circuitos integrados combinaban múltiples transistores en un solo chip, lo que aumentó la capacidad de procesamiento y redujo el tamaño de las máquinas. El IBM System/360 es un icono de esta generación y fue una de las primeras computadoras en utilizar un sistema operativo compatible con diferentes modelos de hardware. Esto permitió a las empresas y organizaciones actualizar sus sistemas sin necesidad de reescribir su software.

Cuarta generación (1971-presente): La invención del microprocesador marcó el inicio de esta generación. Los microprocesadores integran todos los componentes de una CPU en un solo chip, lo que permitió la creación de computadoras personales (PC) accesibles al público general. La Apple II, lanzada en 1977, y el IBM PC, lanzado en 1981, son ejemplos emblemáticos de esta generación. Estas máquinas revolucionaron el uso de las computadoras en el hogar y en las pequeñas empresas, haciendo la tecnología accesible a millones de personas.

Quinta generación (presente y futuro): La quinta generación se caracteriza por el desarrollo de la inteligencia artificial y la computación cuántica. La inteligencia artificial ha permitido la creación de sistemas capaces de aprender y adaptarse, lo que ha revolucionado campos como la medicina, la educación y el entretenimiento. Las computadoras cuánticas, como las desarrolladas por IBM y Google, tienen el potencial de resolver problemas que las computadoras clásicas no pueden, debido a su capacidad para realizar cálculos en paralelo a una velocidad sin precedentes.

La revolución del software y la internet

Con el avance del hardware, también se desarrolló el software. En los años 70 y 80, surgieron los primeros sistemas operativos y lenguajes de programación, como UNIX y C. UNIX fue desarrollado en los laboratorios Bell de AT&T y se convirtió en uno de los primeros sistemas operativos multitarea y multiusuario. El lenguaje de programación C, creado por Dennis Ritchie, permitió la creación de software más eficiente y portable, y se convirtió en la base de muchos otros lenguajes de programación.

La creación de la World Wide Web por Tim Berners-Lee en 1989 revolucionó la forma en que compartimos y accedemos a la información. La web permitió la creación de páginas web interconectadas a través de hipervínculos, lo que facilitó la navegación y la búsqueda de información en línea. La década de 1990 vio el auge de la internet y el nacimiento de gigantes tecnológicos como Microsoft, Google y Amazon. La web 2.0, caracterizada por la interactividad y el contenido generado por los usuarios, transformó la forma en que interactuamos en línea. Plataformas como YouTube, Facebook y Wikipedia permitieron a los usuarios crear y compartir contenido, lo que cambió radicalmente la dinámica de la información y la comunicación.

En paralelo a estos desarrollos, el software de código abierto también comenzó a ganar popularidad. Proyectos como Linux, un sistema operativo desarrollado por Linus Torvalds, demostraron el poder de la colaboración global en la creación de software. Linux y otros proyectos de código abierto han sido fundamentales para el desarrollo de la infraestructura de internet y la innovación en la informática.

La era de la inteligencia artificial y la computación cuántica

En el siglo XXI, la inteligencia artificial (IA) y la computación cuántica están revolucionando la informática. La IA, con aplicaciones en reconocimiento de voz, visión por computadora y procesamiento del lenguaje natural, está transformando industrias enteras. Algoritmos de aprendizaje automático, como las redes neuronales profundas, han permitido avances significativos en el reconocimiento de patrones y la toma de decisiones automatizada. Empresas como Google, Microsoft y Amazon están utilizando la IA para mejorar sus productos y servicios, desde asistentes virtuales hasta sistemas de recomendación.

La computación cuántica, aún en sus primeras etapas, promete resolver problemas complejos en campos como la criptografía, la química y la física. Las computadoras cuánticas utilizan qubits, que pueden representar tanto 0 como 1 simultáneamente, lo que permite realizar cálculos a una velocidad sin precedentes. Empresas como IBM, Google y Microsoft están liderando el desarrollo de computadoras cuánticas, y se espera que esta tecnología tenga un impacto profundo en la investigación científica y la industria.

Un ejemplo destacado es el procesador cuántico Sycamore de Google, que en 2019 logró realizar un cálculo en 200 segundos que habría tomado miles de años con una supercomputadora clásica. Este hito, conocido como “supremacía cuántica”, demuestra el potencial de la computación cuántica para abordar problemas que están fuera del alcance de las computadoras convencionales.

Impacto de la informática en la sociedad

La informática ha tenido un impacto profundo en la sociedad, transformando la manera en que vivimos, trabajamos y nos comunicamos. La digitalización ha facilitado el acceso a la información y ha democratizado el conocimiento, permitiendo que personas de todo el mundo se conecten y colaboren.

En el ámbito de la salud, la informática ha revolucionado la investigación médica y el tratamiento de enfermedades. La bioinformática y la genómica han permitido avances significativos en la comprensión del ADN y el desarrollo de terapias personalizadas. Los sistemas de información de salud han mejorado la gestión de datos médicos y la atención al paciente, reduciendo errores y mejorando la eficiencia.

En la educación, las tecnologías de la información han ampliado el acceso a recursos educativos y han facilitado el aprendizaje a distancia. Las plataformas de aprendizaje en línea, como Coursera, edX y Khan Academy, ofrecen cursos de alta calidad a millones de estudiantes en todo el mundo. La inteligencia artificial también está siendo utilizada para personalizar la educación, adaptando el contenido y el ritmo de aprendizaje a las necesidades individuales de los estudiantes.

En el mundo empresarial, la informática ha transformado la manera en que las empresas operan y compiten. La automatización de procesos, el análisis de big data y la inteligencia artificial están permitiendo a las empresas tomar decisiones más informadas y optimizar sus operaciones. Las tecnologías de la información también han facilitado la creación de nuevos modelos de negocio y la innovación en productos y servicios.

La informática también ha tenido un impacto significativo en la comunicación y las relaciones sociales. Las redes sociales y las aplicaciones de mensajería han cambiado la manera en que nos conectamos con amigos y familiares, permitiendo una comunicación instantánea y global. Sin embargo, también han planteado desafíos en términos de privacidad y seguridad de la información.

Desafíos y consideraciones éticas

A medida que la informática avanza, también surgen nuevos desafíos y consideraciones éticas. La inteligencia artificial, en particular, plantea preguntas importantes sobre la privacidad, la seguridad y el impacto en el empleo. Los algoritmos de IA pueden sesgarse y perpetuar desigualdades existentes si no se desarrollan y utilizan de manera responsable. Es esencial establecer marcos éticos y regulaciones para garantizar que la tecnología se utilice de manera justa y equitativa.

La seguridad cibernética es otro desafío crítico en la era digital. A medida que dependemos cada vez más de la tecnología para nuestras actividades diarias, también aumentan los riesgos de ciberataques y violaciones de datos. Es crucial desarrollar tecnologías y prácticas de seguridad avanzadas para proteger la información y mantener la confianza en los sistemas digitales.

La computación cuántica, aunque prometedora, también plantea desafíos en términos de seguridad. La capacidad de las computadoras cuánticas para romper los sistemas de encriptación actuales podría tener implicaciones significativas para la privacidad y la seguridad de la información. Es necesario desarrollar nuevas técnicas de encriptación cuántica para proteger los datos en la era de la computación cuántica.

El futuro de la informática

El futuro de la informática promete ser tan emocionante y transformador como su historia. Las tecnologías emergentes, como la inteligencia artificial, la computación cuántica, el internet de las cosas (IoT) y la realidad aumentada y virtual, continuarán impulsando la innovación y abriendo nuevas oportunidades.

La inteligencia artificial seguirá evolucionando y mejorando, con aplicaciones cada vez más sofisticadas en áreas como la medicina, la educación, el transporte y el entretenimiento. Los avances en el aprendizaje automático y el procesamiento del lenguaje natural permitirán la creación de sistemas más inteligentes y autónomos.

La computación cuántica, aunque todavía en sus primeras etapas, tiene el potencial de revolucionar la ciencia y la tecnología. A medida que se superen los desafíos técnicos y se desarrollen aplicaciones prácticas, la computación cuántica podría transformar campos como la criptografía, la simulación de materiales y la optimización de procesos complejos.

El internet de las cosas continuará conectando dispositivos y sistemas, creando un entorno más integrado e inteligente. Los hogares inteligentes, las ciudades inteligentes y las fábricas inteligentes mejorarán la eficiencia y la calidad de vida, pero también plantearán desafíos en términos de seguridad y privacidad.

La realidad aumentada y virtual ofrecerá nuevas formas de interacción y experiencia, desde la educación y el entretenimiento hasta la capacitación y el diseño. Estas tecnologías permitirán experiencias inmersivas y personalizadas, cambiando la manera en que interactuamos con el mundo digital.

Conclusión

La historia de la informática es una historia de innovación y progreso continuo. Desde los primeros dispositivos de cálculo hasta las avanzadas computadoras cuánticas y la inteligencia artificial, la informática ha cambiado la forma en que vivimos y trabajamos. A medida que continuamos avanzando en el siglo XXI, es emocionante imaginar qué nuevos desarrollos y descubrimientos nos deparará el futuro.

La informática ha demostrado ser una fuerza transformadora en nuestra sociedad, y su impacto seguirá creciendo en los años venideros. A medida que exploramos nuevas fronteras tecnológicas, es esencial abordar los desafíos éticos y de seguridad que surgen, y garantizar que los beneficios de la tecnología se distribuyan de manera justa y equitativa.

Más snaks

-

Economía mundial y tendencias 2026: implicaciones para la educación superior

La economía mundial y tendencias 2026 marcan un momento clave para comprender los retos estructurales que enfrentan los países, las instituciones y las universidades. En un escenario caracterizado por crecimiento moderado, tensiones geopolíticas, transformaciones tecnológicas aceleradas y reconfiguración de cadenas productivas, analizar la economía mundial y tendencias actuales no es solo un ejercicio macroeconómico, sino […]

-

Encuesta SEP sobre el uso de la IA en estudiantes y profesores

La encuesta de la SEP sobre el uso de la IA en estudiantes y profesores revela con claridad que la inteligencia artificial ya es parte estructural de la educación superior en México. No se trata de una herramienta marginal ni experimental: los datos muestran una adopción masiva que obliga a reflexionar con seriedad sobre sus […]

-

Sarampión y alfabetización científica: la educación sigue siendo clave

El sarampión y la alfabetización científica vuelven al centro del debate público en un contexto donde las búsquedas digitales, los rumores en redes sociales y la circulación acelerada de información exigen algo más que reacciones emocionales: exigen formación sólida. El resurgimiento de casos de sarampión en distintos países no es únicamente un asunto epidemiológico; es […]